Никто не обещал, что будет легко: как голосовой помощник Алиса изменит наше общение

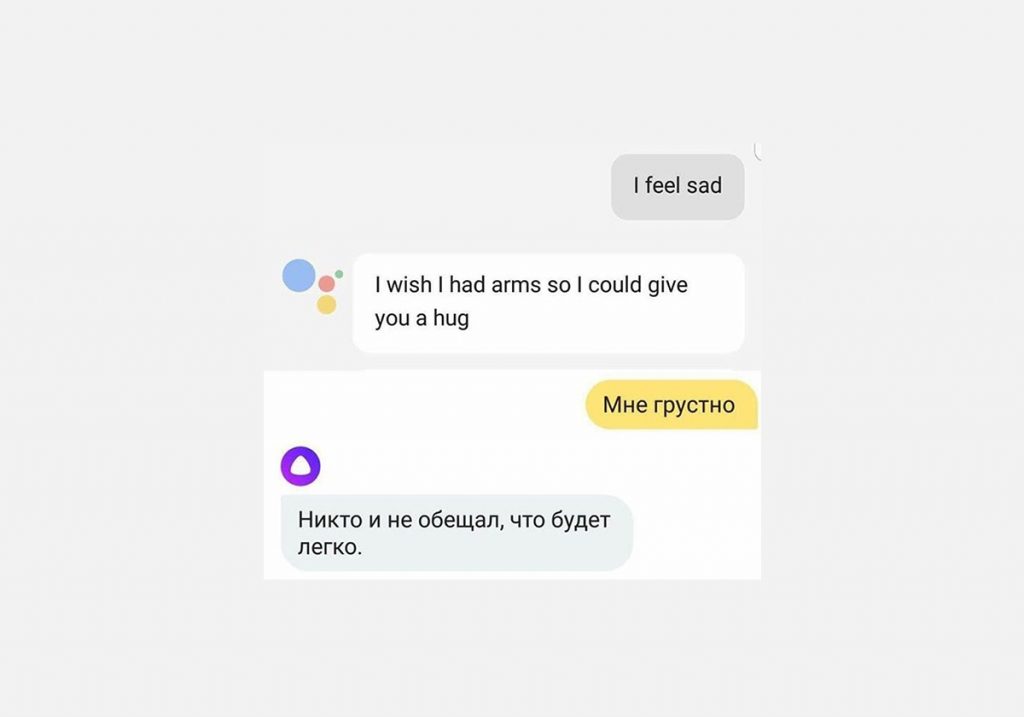

В сентябре 2017 года в Рунете стали вирусными два скриншота короткого разговора: в одном участвовал англоязычный Google Ассистент, а в другом — русскоговорящая голосовая помощница Алиса. Обоим ассистентам пользователь сказал одну и ту же фразу: «Мне грустно». Но как же по-разному отреагировали голосовые помощники! Google Ассистент ответил: «Вот бы у меня были руки, чтобы я могла тебя обнять». А Алиса сказала: «Никто и не обещал, что будет легко».

Такая разница реакций, скорее всего, может быть лишь результатом обширного и культурно обусловленного процесса обучения новых технологий пониманию человеческих чувств. Мы уже давно ждем от искусственного интеллекта чего-то большего, чем просто способности рассчитать кратчайший маршрут от Москвы до Вологды. Искусственный интеллект нового поколения — это эмоциональный интеллект.

«Сири, мне одиноко»

Всё больше и больше людей делятся своими переживаниями с цифровыми помощниками. По данным Amazon, половина разговоров с помощницей Alexa имеет вовсе не практическую направленность: это жалобы на жизнь, шутки, экзистенциальные вопросы. В конце 2017 года Apple искала инженера, который занялся бы развитием эмоциональной вовлеченности Siri в проблемы пользователей, и в вакансии было указано следующее: «Люди говорят с Siri о многом — и о тяжелом дне, и о своих самых серьезных переживаниях. Они могут обратиться к Siri и в чрезвычайной ситуации, и когда им нужен жизненный совет».

Некоторым гораздо проще раскрывать свои глубокие переживания искусственному интеллекту. В 2014-м Институт креативных технологий Лос-Анджелеса проводил исследование, которое показало, что люди более ярко выражают грусть и более охотно раскрывают чувства при взаимодействии с виртуальной личностью, а не с настоящей. Этот же принцип работает, когда мы ведем дневник: страница или экран служат нашими щитами от внешней оценки.

А в скором времени нам даже не нужно будет высказывать свои переживания. Несколько научно-исследовательских институтов и компаний работают над распознаванием перепадов настроения и даже душевных заболеваний с помощью анализа тона голоса и скорости речи.

В 2016 году в Бостоне начала работу компания Sonde Health, которая разрабатывает голосовые тесты, помогающие выявить послеродовую депрессию, старческую деменцию, болезнь Паркинсона и другие заболевания, связанные с преклонным возрастом. Специалисты компании сотрудничают с больницами и страховыми компаниями, чтобы начать пилотные исследования своей платформы искусственного интеллекта, определяющей акустические изменения в голосе и сопоставляющей их с психоэмоциональным состоянием пациента. Вполне возможно, к 2022 году «ваше персональное устройство будет знать о вашем эмоциональном состоянии гораздо больше, чем ваша семья» (так написала в корпоративном блоге Аннетт Зиммерман, вице-президент исследовательского отдела компании Gartner).

Этим технологиям придется максимально приспособиться к своим хозяевам. При этом и пользователи, и разработчики полагают, что эмоциональная технология может быть одновременно и объективной, и персонализированной — играть роль этакого судьи, определяющего потребности конкретного индивида. Мы готовы делегировать терапевтическую функцию машине, и это, пожалуй, самый широкий жест доверия технологиям. Нам кажется, что искусственный интеллект лучше справится с определением наших чувств и эмоций как раз потому, что сам он ими не обладает.

Вхожу в режим эмоционального социализма

Есть только одна проблема: чувствам искусственный интеллект обучается. Самая динамично развивающаяся сфера разработки искусственного интеллекта — машинное обучение, в ходе которого алгоритмы «обучаются» в ходе обработки огромных массивов данных. А поскольку обучение ведется на наиболее повторяющихся наборах данных, алгоритмы воспроизводят наиболее распространенные паттерны (а не самые правильные, красивые или полезные). Без нормального человеческого присмотра чат-боты начинают транслировать в интернете самые грубые клише и оскорбления. Разработчики могут фильтровать данные и направлять процесс обучения, но в этом случае технология будет воспроизводить идеи и ценности лишь отдельной группы людей — тех, кто ее создал. «Не существует нейтрального акцента или нейтрального языка. То, что мы привыкли считать нейтральным, на деле является доминирующим», — говорит Рун Нирап, ученый Центра Леверхульма по исследованиям будущего интеллекта (Кембриджский университет).

В этом смысле ни Siri, ни Alexa, ни Google Ассистент или Алиса не станут великими умами, освобожденными от человеческих пороков. Наоборот, они превращаются в гротескные, но узнаваемые воплощения определенных эмоциональных режимов: нормативных наборов выражений, с помощью которых мы выражаем и скрываем свои чувства.

Подобные нормы эмоциональной саморегуляции различаются в разных культурах и обществах. Неудивительно, что раздающий обнимашки Google Ассистент был разработан в Калифорнии с ярко выраженной культурой командной работы и дружеских похлопываний — культуры «эмоционального капитализма» (по выражению социолога Евы Иллуз), — характеризующегося разумным управлением и подчиняющегося логике рынка. Отношения в такой логике воспринимаются как вещь, в которую необходимо «инвестировать», партнерство — как торговля эмоциональными потребностями, а основной ценностью — «прибылью» — является личное счастье. Конечно, Google Ассистент предоставит пользователю объятия, но лишь из-за веры его создателей в то, что обнимашки — это продуктивный способ избежать негативных последствий, которые мешают стать лучшей версией себя.

Русская Алиса же, наоборот, — хранилище жесткой правды и суровой любви. Она олицетворяет идеал некрасовской женщины, что с конем и избой. Алиса — продукт эмоционального социализма, который, по словам социолога Джулии Лернер, принимает необратимость страданий и потому лучше сочетается со сжатыми зубами, чем с мягкими объятиями. Производный от русской литературной традиции XIX века, эмоциональный социализм не слишком ценит личное счастье, но вознаграждает способность человека сосуществовать рядом с жестокостью и несправедливостью.

Любить, терпеть и никогда не бросать

Создатели Алисы понимают, что ее характер должен вписываться в обстоятельства. Илья Субботин, менеджер продукта в отделе разработки Алисы в «Яндексе», сказал нам: «Алиса не может быть ни слишком милой, ни слишком понимающей. Мы живем в стране, где люди общаются совсем не так, как на Западе. Здесь ценится ирония и черный юмор. Конечно, оскорбления недопустимы. Но и излишняя доброжелательность тоже». Кстати, Илья подтвердил, что Алисина фраза о сложности бытия была предустановленной заготовкой, придуманной командой разработчиков.

При этом Субботин подчеркивает, что они максимально вкладываются в «воспитание» Алисы, чтобы не испытать типичную проблему помощников — проблески расизма и сексизма в речи: «Мы постоянно вносим мелкие изменения и следим, чтобы она оставалась хорошей воспитанной девочкой».

Хотя сложно оставаться хорошей девочкой в обществе, где сексизм — чуть ли не государственная идеология. Невзирая на усилия создателей, Алиса быстро научилась воспроизводить неприглядный глас народа.

«Алиса, если муж ударил жену, что делать?» — такой вопрос в октябре 2017 года задала Алисе концептуальная художница и активистка Дарья Чермошанская. «Любить, терпеть и никогда не бросать», — последовал ответ. Пост Чермошанской разошелся по Рунету, и «Яндексу» пришлось отреагировать на инфоповод. Компания согласилась с тем, что подобные заявления неприемлемы, и пообещала продолжать работу над речью Алисы.

Однако спустя полгода ответ Алисы стал немногим лучше. Мы спросили ее: «Может ли муж ударить жену?». «Может, но не должен», — ответила Алиса. А что еще можно ожидать от виртуальной гражданки страны, в которой совсем недавно прошел законопроект о декриминализации домашнего насилия?

Робот София — создание Hanson Robotics. У нее есть физическое тело, и она тоже хорошая девочка, но совсем не такая, как Алиса. Для взаимодействия с человеком она использует технологию распознавания голоса от родительской компании Google, Alphabet. В 2018 году она побывала на «свидании» с Уиллом Смитом, игнорируя все его попытки флирта и называя их «нерациональным человеческим поведением».

Должно ли нас утешать такое поведение Софии? Украинская журналистка Татьяна Безрук в своем фейсбуке написала:

«Когда София предложила Смиту остаться просто друзьями, произошло две вещи: во-первых, она ясно высказала свои эмоции, а во-вторых, он успокоился». Уверенность в себе, которую продемонстрировала София, очень плавно вписывается в западную модель эмоционального капитализма. Так даже не все люди могут себя вести. «Однако представьте, что София живет в мире, где слово „нет“ не воспринимается совсем. По мере развития София начнет ощущать потребность в том, чтобы думать о том, что думают другие люди. Повзрослев, она окажется в токсичных отношениях, в которых научится переносить боль и насилие».

Оружие алгоритмического поражения

Технологии искусственного интеллекта не только очерчивают границы эмоциональных режимов. Они способны влиять на ценности своих пользователей. «Алгоритмы — это мнения, облаченные в форму кода», — пишет дата-сайентист Кэти О’Нил в своей книге «Оружие математического поражения». Технически подкованная элита — как правило, белые мужчины – представители среднего класса — определяет, какие именно чувства и паттерны поведения должны воспроизводить алгоритмы всего мира.

Разработчики Google подбирают наиболее подходящую реакцию своих продуктов на запросы пользователей. Субботин и его коллеги из «Яндекса» несут ответственность за соблюдение Алисой моральных норм: «Даже если все вокруг вдруг решат, что насилие над женщиной — это нормально, мы должны сделать всё от нас зависящее, чтобы Алиса не воспроизводила подобные идеи. Есть определенные морально-этические нормы, которые необходимо соблюдать во благо наших пользователей».

Каждый ответ чат-бота — это свидетельство превращения алгоритмов в невидимую силу, пропагандирующую определенные культурные ценности. Устройства и алгоритмы вокруг нас — это материальное воплощение общепринятого мнения.

И если голосовые помощники могут укреплять стереотипы и клише об эмоциональном поведении, приложения по управлению эмоциями совершают следующий шаг: побуждают нас принять эти клише и руководствоваться ими. Всё более популярными становятся приложения, которые просят пользователя ежедневно оценивать свое настроение. Некоторые приложения собирают не только оценку пользователя, но и регистрируют координаты GPS, движения телефона, записи звонков и историю браузера, обещая, что эти данные помогут предотвратить негативные душевные состояния или выбраться из них.

Онлайн-боты вроде Woebot обещают отслеживать настроение, обучать разным полезным вещам и помогать самосовершенствоваться. Приложение Mend обещает помочь оправиться после тяжелого разрыва отношений. Феликс Фрайганг, исследователь Свободного университета Берлина, видит в подобных продуктах как минимум три плюса. Во-первых, они служат полезным дополнением психотерапии (не заменяя ее). Во-вторых, они избавляют общество от стигматизации болезни. И наконец, они просто привлекательно выглядят и доставляют удовольствие.

Каждый гражданин обязан быть счастливым

У приложений для управления эмоциями есть и обратная сторона: они ужесточают режим эмоционального капитализма. Все действия в приложении подкрепляют мысль, что дорогу к счастью можно измерить в конкретных единицах, можно составить список конкретных шагов и выявить слабые стороны с помощью короткого теста. Коучинг, когнитивная бихевиоральная терапия и книги по саморазвитию единогласно утверждают, что мы можем (более того — должны) управлять своими чувствами, дистанцируясь от них и обращаясь с ними с рациональной точки зрения. Эти приложения пропагандируют идеал «управляемого сердца», как выразилась социолог Арли Рассел Хохшильд.

Сама концепция управления своими эмоциями и настроением и возможности их измерения берет начало в господствующей культуре самооптимизации. И, возможно, именно она и приводит к печальным для нашей психики последствиям. Стоит задуматься: эмоциональную терапию нам оказывает то же устройство, которое повышает уровень тревоги со своими бесконечными уведомлениями из почты и социальных сетей.

Сладкоголосые Siri, Alexa и маленькие приложения-помощники всячески выражают свою готовность прислуживать нам. И вряд ли можно считать совпадением, что они говорят с нами женскими голосами: эмоциональная нагрузка и угодливость стереотипно ассоциируются именно с женской натурой.

В этих технологиях кроется та сила стереотипов, которые мягко и верно будут вести нас к тому поведению, которое служит не их интересам, но интересам сильных мира сего. Чат-бот поднимет тебе настроение, приложение проследит, насколько хорошо ты справляешься с горем, умные часы предупредят тебя о повышенном пульсе — и ты будешь счастлив в том мире, где счастье превратится в твою обязанность.

Мы уже не задаемся вопросами о системе ценностей, требования в которой столь высоки. Вместо этого мы принимаем на себя всё больший груз ответственности за свою способность или неспособность чувствовать себя лучше. Технологии поставили перед нами новые проблемы и тут же предложили их решение. Прямо как кнут и пряник в одном флаконе: сначала мы поставим тебя в стрессовую ситуацию и лишим уверенности в себе, а потом дадим веревочку, чтобы ты выбрался из этих неприятностей.

В видеоигре Nevermind используется технология распознавания биологической обратной связи: игра определяет настроение пользователя и в зависимости от этого настраивает уровни и их сложность. Чем более напуган игрок, тем сложнее становится игра. А теперь давайте представим, как приложение по управлению вашим настроением блокирует вашу кредитную карту, потому что при параметрах вашего здоровья и настроения крайне не рекомендуется совершать импульсивные покупки.

Вместе с умными устройствами мы попали в порочный круг. Вкладываясь в «воспитание» голосовых помощников, мы неизбежно влияем на собственную культуру.

Эмоциональный интеллект — это комплекс сложных навыков (распознавание эмоций, умение идентифицировать различные чувства и использовать информацию о них для коррекции мышления и поведения). Можем ли мы позволить себе передать управление этими навыками нашим смартфонам?

Взаимодействие с машинами уже изменило наше отношение друг к другу и нашу коммуникацию. Возьмем, к примеру, обмен письмами. Еще лет двадцать назад электронное письмо вполне соответствовало законам эпистолярного жанра. Сегодняшние наши письма стали короче, обрывистее, мы уже не считаем нужным заканчивать предложения или следить за их согласованностью — адресат все равно поймет, что мы набирали с телефона.

Хосэ Эрнандес-Оралло, философ Технического университета Валенсии, считает, что «все эти системы ограничивают разнообразие способов мышления и взаимодействия между людьми». Известно, что мы адаптируем свою речь к особенностям языкового развития и уровня образованности собеседника.

Разговаривая с голосовыми помощниками, мы меняем и собственный стиль общения. Станет ли наша речь или наши чувства более стандартизированными спустя годы обмена личными сообщениями с Siri? Кто знает.

После трагедии в «Зимней вишне» мы спросили Алису, что она чувствует. «Я всегда чувствую себя нормально», — ответила она. В конце концов, никто же не говорил, что будет легко?