От игральных костей до нейросетей. Краткая история генеративной музыки

Искусственный интеллект сегодня может «оживить» голоса умерших артистов, но гораздо больший ажиотаж вызывает у живых: одних исполнителей обвиняют в использовании дипфейков собственных голосов при записи новых треков, а другие бьют тревогу и требуют законно урегулировать их использование. Но как мы вообще дошли до положения, в котором музыка может создаваться практически без вмешательства человека?

Случайности случайны!

Понятие генеративной музыки принято ассоциировать с именем британского композитора Брайана Ино, который прочитал по этой теме лекцию на Imagination Conference в Сан-Франциско в 1996-м году. В ней он говорит о таком типе музыки, которая должна длиться вечно, воспроизводиться без помощи музыкантов, никогда не повторяться и следовать определенным правилам (заданному алгоритму). Сам Ино пытался создать нечто подобное еще с середины 1970-х на своих ранних эмбиент-альбомах «Discreet Music» (1975) и «Ambient 1: Music for Airports» (1978), запуская одновременно несколько магнитных лент на разной скорости.

Впрочем, попытки добавить эффект непредсказуемости в сочинение музыки существовали еще задолго до появления звукозаписывающей аппаратуры. Так, в конце XVIII в. в Европе стала особенно популярна шуточная «Музыкальная игра в кости» (нем. Musikalisches Würfelspiel) – композиторы бросали кости, подставляли значения в таблицу и вот в таком случайном порядке соединяли музыкальные секвенции. Особенно известны были игры Вольфганга Амадея Моцарта и Йозефа Гайдна, хотя еще за несколько десятилетий до них, в 1757-м году, к данной практике обращался немецкий теоретик музыки и композитор Иоганн Филипп Кернбергер.

По сути, старинные музыкальные игры с костями уже недалеко ушли от генеративной музыки по Брайану Ино – в них есть элемент случайности, определенные правила, по которому собирается композиция, тысячи вариантов итоговой сборки – разве что длятся они не вечно, ограничиваясь стандартной продолжительностью заданного музыкального жанра (обычно это был менуэт, длящийся по две-четыре минуты).

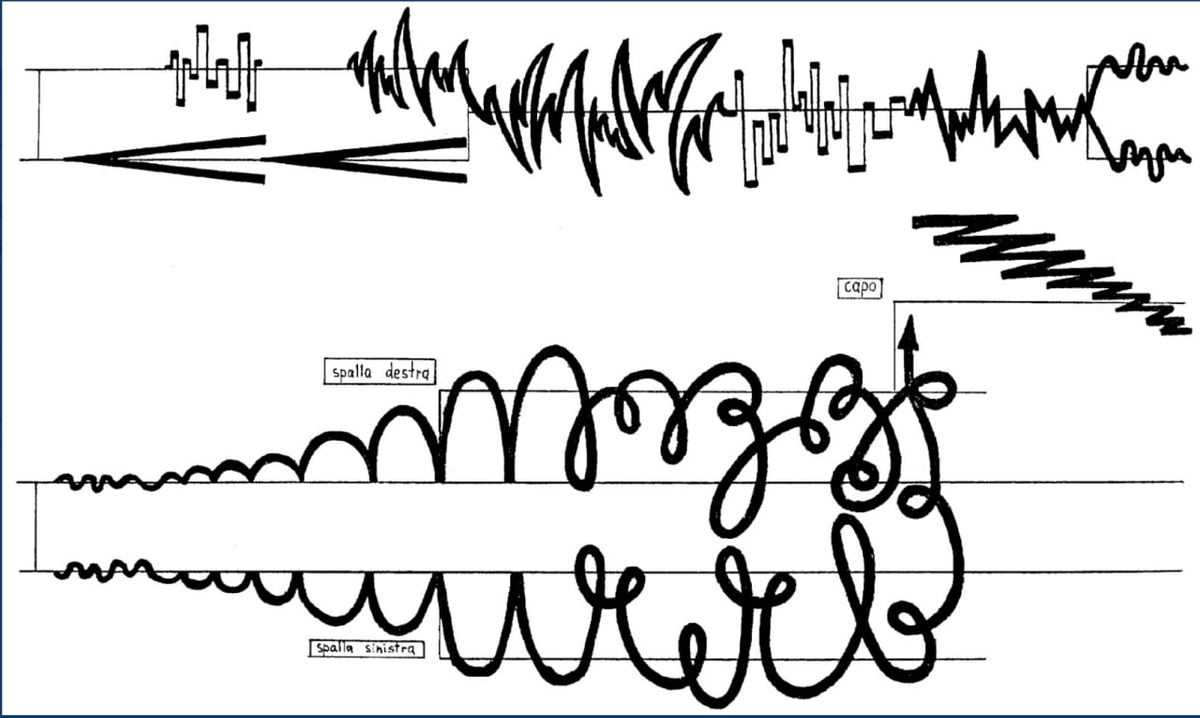

В середине XX в. идея соединения музыки с комбинаторикой перекочевала в авангард академической музыки – такие композиторы как Джон Кейдж, Терри Райли, Карлхайнц Штокхаузен, Стив Гласс, Пьер Булез и другие добавляли в свои композиции элементы случайности и неопределенности, в то время как саму технику стало принято называть «алеаторикой». Суть техники заключается в параллельном проигрывании нескольких магнитных лент с идентичными записями звука, которые со временем рассинхронизируются и постоянно меняют интервалы относительно друг друга, долго не возвращаясь в исходное положение. Услышать такое можно в композициях «It’s Gonna Rain» (1965) и «Come Out» (1966), которые основаны на буквально двухсекундных записях человеческого голова.

Власть компьютера

Все на той же лекции в 1996-м году Брайан Ино ставил на генеративную музыку большие надежды. Он вопрошал: «Возможно, наши внуки будут смотреть на нас с удивлением и спрашивать: «Вы серьезно говорите, что вам приходилось слушать одно и то же снова и снова?». И как раз в 90-е у него было достаточно оснований полагать, что именно такое будущее ждет музыкальное сознание людей XXI в. Компьютеры все больше входили в разные сферы жизни человечества, в том числе – в сферу композиторства и звукозаписи, а значит генерировать бесконечные музыкальные пространства стало возможно быстрее и проще.

Параллельно с появлением первых DAW (англ. Digital Audio Workspace – цифровое рабочее место для работы с аудио) на рынок компьютерного софта поступали и более экспериментальные программы – например, SSEYO Koan 1994-о года, которая как раз выглядела и работала как таблица для создания систем звуковых алгоритмов. Альбом «Generative Music I» (1996) года снова за авторством Брайана Ино как раз наглядно демонстрировал возможности программы.

Таким образом, вопрос разработки различного рода софта для компьютерной генеративной музыки оказывается важнее композиторского вмешательства в процесс. Можем ли мы тогда считать эту музыку человеческой?

Золотая эра

«Золотой эрой» генеративной музыки можно назвать период между 2019-м и 2020-м годами. Тогда на рынок вышло множество мобильных приложений, которые могут создавать музыку на ходу – иногда даже буквально подстраиваясь под темп ходьбы слушателя, как Holon. Среди всех стоит выделить Mubert, создающий разную ритмичную электронику на фон, и Endel, работающий от нейросети и имеющий кучу настроек для создания эмбиента. В те годы как раз были популярны бесконечные радио с фоновой музыкой для работы и другой деятельности (самое известное из таких крутило легкие хип-хоп биты, будто бы оцифрованные с кассетной пленки).

В это же время генеративная музыка проникает в западную поп-индустрию, пусть пока и среди более экспериментальных артистов. Так, американская певица Grimes в 2020-м году поучаствовала в обновлении уже упомянутого выше приложения Endel, в котором в него добавился звуковой ландшафт, обученный на голосе и музыке артистки. А венесуэльская электронная исполнительница Arca выпустила 100 (!) хаотичных ремиксов на свой трек «Riquiqui», сделанных при помощи искусственного интеллекта Bronze.

А что сейчас?

В 2025-м году музыкальные нейросети умеют делать то, чего не умели 5 лет назад – хорошо генерировать человеческий голос. Теперь вместо того, чтобы создавать инструментальные абстракции в стиле определенных жанров, музыканты активно используют нейросети, натренированные на чьем-либо голосе, чтобы использовать его вокал в своей композиции. Например, есть доказательства того, что Канье Уэст на своем альбоме «Vultures 2» использовал ИИ-генератор собственно голоса, а также существует рэп-«артист» TWXN, который собирает миллионы прослушиваний с песен, записанных при помощи искусственно воссозданного голоса рэпера Playboi Carti.

С другой стороны, развитие больших языковых моделей дало толчок к появлению более совершенных генеративных музыкальных нейросетей. Наиболее известной из таких является Suno AI, которая позволяет генерировать песни при помощи персонально настроенного запроса любой сложности – можно указывать комбинации жанров, тембр голоса, текст, настроение и многое другое.

По ту сторону закона

Вернемся к недавно появившейся возможности беспрепятственно создавать цифровую копию голоса любого вокалиста. Очевидно, такое присваивание вызывает множество вопросов, в том числе, юридических. Можно ли копировать голос другого человека без разрешения и создавать с его помощью записи музыкальные и другие записи? Является ли человеческий голос интеллектуальной собственностью?

Единого мнения на этот счет нет. С одной стороны, американская певица Билли Айлиш, рок-исполнитель Мак ДеМарко и еще более двухсот (!) известных музыкальных деятелей подписывают письмо, в котором призывают корпорации остановить распространение любого материала, связанного с генерацией голосов. С другой, упомянутый «рэпер» TWXN постоянно использует голос Playboi Carti и зарабатывает на этом деньги, а британские тролли-электронщики Two Shell выпускают в качестве «прогрева» к синглу «Talk to Me» версии трека с дипфейк-вокалом Тэйлор Свифт, Фрэнка Оушена и некоторых других.

Английская певица FKA twigs, которая стала настоящей вокалисткой на вышеназванном треке Two Shell, заявляет об опасности дипфейков для артистов, если те окажутся в руках недобросовестных третьих лиц. При этом она параллельно самостоятельно разрабатывая ИИ-версию себя – чтобы пользоваться теми же возможностями от первого лица. А Grimes, например, просит фанатов свободно использовать «ее» вокал, сгенерированный при помощи ИИ.

Кто бы ни оказался прав в этом правовом противостоянии, одно можно сказать наверняка – генеративная музыка даже спустя почти 30 лет после появления вызывает вопросы о смысле авторства, о том, что вообще можно называть «музыкой», а также будоражит творческие умы, наиболее открытые к технологическим инновациям.