Я не робот. Кто лучше проходит тесты на человечность — машины или люди

Идея искусственного разума долгое время будоражила воображение философов, фантастов и изобретателей, хотя серьезные исследования в этой области начались только в середине прошлого века. Сегодня человечество, кажется, как никогда близко к воплощению этой мечты. Чуть ли не каждый день заголовки в СМИ кричат об успехах и угрозах ИИ. Нейросети создают такие тексты и изображения, что отличить результат их деятельности от человеческого всё сложнее. К счастью, уже давно придуманы тесты, призванные определить, кто их проходит — человек или робот. Но достаточно ли эффективны эти тесты? И не играют ли они на самом деле на руку ИИ? Рассказываем историю инструментов по различению машин и людей — от теста Тьюринга до последних версий капчи.

Выпускной экзамен для ИИ

История знаменитого теста, различающего искусственный и человеческий разум, началась за несколько десятилетий до создания первых компьютеров в их сегодняшнем понимании, а его философские предпосылки уходят корнями в далекое прошлое. Традиционно тест Тьюринга связывают с трактатом Рене Декарта 1637 года «Рассуждение о методе». Декарт подчеркивает важность «здравого смысла», под которым подразумевает природную способность людей отличать истину от заблуждения. Сравнивая интеллект животных и человека, философ предлагает мысленный эксперимент с участием автомата (automata), или двигающейся машины. По мнению Декарта, если когда-нибудь будет создан механизм, в точности копирующий внешность и поведение животного, мы не сможем достоверно утверждать, что они не являются одинаковыми по своей сущности. Однако если будет создан механический клон человека, у нас будет как минимум два способа различить их. Во-первых, такая машина не будет пользоваться речью так же, как мы:

«Можно, конечно, представить, что машина будет сконструирована так, что сможет произносить слова и даже реагировать на прикосновения <…>. Например, если тронуть ее в одном месте, она спросит, что мы хотим ей сказать; если в другом, она воскликнет, что ей больно, и так далее. Однако она никогда не сможет строить фразы и уместно отвечать на все, сказанное в ее присутствии, — что может делать даже самый никчемный из людей».

Говоря о втором отличии, Декарт допускает, что в некоторых отношениях машины могут намного превосходить людей. Однако их действия обусловлены не знаниями, а всего лишь расположением органов (частей механизма). Действия человека имеют причину, мотив; действия автомата обуславливаются лишь программой. Во времена Декарта уже пользовались популярностью механические куклы, которые изображали животных и людей за их повседневными занятиями. В последующие века такие куклы становились все более сложными: они могли рисовать картинки, играть на пианино и даже стрелять из лука. Однако, без сомнения, набор их действий и слов (когда таковые присутствовали) был сильно ограничен.

Декарт не имел возможности вообразить, каких успехов добьются роботы будущего при прохождении первой части его «теста» на человечность, а вот со второй у них до сих пор проблемы.

Хотя инженеры, работая над андроидами, добились поразительных успехов. В декабре 2021 года компания Engineered Arts представила миру гуманоидного робота Ameca. Амека далеко не первая модель андроида; в 2015 году гонконгской компанией Hanson Robotics была выпущена София — человекоподобный робот в виде женщины. София неоднократно давала интервью СМИ, участвовала в ток-шоу «Вечерний Ургант» в России и даже получила подданство Саудовской Аравии, что сделало ее первым роботом с гражданством. Однако именно об Амеке говорят как об андроиде, наиболее приближенном внешне к человеку. Хотя цвет ее лица серый и она пока не умеет ходить, плавность и естественность движений, оживленная мимика делают ее похожей на человека, но не вызывают эффекта Зловещей долины. Впрочем, нам пока не нужны специальные тесты, чтобы внешне отличить андроида от человека, но что насчет их разума?

Предпосылки появления теста Тьюринга можно проследить не только в философских трактатах, но и в более развлекательной литературе — научной фантастике. Профессор Университета Калгари Дженис Эрнест Свилпис в статье «Научно-фантастическая предыстория теста Тьюринга» предполагает, что фантасты с 1930-х годов подталкивали читателей (среди которых мог оказаться и Алан Тьюринг) к идее существования альтернативного разума и необходимости методов его выявления. Американский фантаст Джон Вуд Кэмпбелл однажды обратился к своим коллегам:

«Опишите мне существо, которое думает так же хорошо, как человек, или даже лучше, но не как человек».

Предположительно первым, кто сделал это, был Стенли Грумен Вейнбаум — молодой автор, чье творчество заслужило восхищение более поздних представителей Золотого века научной фантастики, в числе которых был и Айзек Азимов. Вейнбаум писал об инопланетном и искусственном разуме. Среди других фантастических произведений об ИИ, возможно, повлиявших на создание теста Тьюринга, Свилпис отмечает «Хелен О’Лой» (1938) Лестера дель Рея, серию рассказов о роботе Адаме Линке «Я, Робот» (1939) Эндо Биндера, «Робби» (1940) Айзека Азимова и «Эл Стоу» (1941) Эрика Фрэнка Рассела.

Впрочем, школьные учителя самого́ Алана Тьюринга утверждали, что мальчик пренебрежительно относится к гуманитарным наукам. Список книг, которые он брал в библиотеке, подтверждает, что он не был поклонником художественной литературы: из 33 наименований только три принадлежали к этой категории: «Алиса в стране чудес» и «Алиса в Зазеркалье» Льюиса Кэрролла, а также «Клуб побегов» А. Дж. Эванса.

Родившийся 23 июня 1912 года Алан Тьюринг поступил в частную школу Шерборн в возрасте 13 лет. Алан с ранних лет был одаренным ребенком, но учителям не нравилась его зацикленность на точных науках, ведь ученики частных школ должны быть хороши во всем. Впрочем, мальчик был упорен в своих предпочтениях и много занимался самостоятельно. В шестом классе математику преподавал ему Дональд Эперсон. Он был сторонником «развлекательной математики», полагая, что она позволяет детям самостоятельно исследовать проблемы и головоломки, и знакомил своих учеников с произведениями Льюиса Кэрролла. Именно этот педагог вдохновил Тьюринга на чтение «Алисы в Стране чудес» и привил любовь к разгадыванию шифров и головоломок, что в 1939 году привело Алана в Блетчли-парк, где он вместе с другими великими умами трудился над расшифровкой кодов стран Оси и разработал метод взлома немецкой шифровальной машины «Энигма».

О важной работе, проделанной Тьюрингом в Блетчли-парке, написаны книги и сняты фильмы, однако словосочетание «тест Тьюринга» на слуху даже у тех, кто ничего не знает о биографии ученого. В октябрьском выпуске британского журнала Mind за 1950 год Алан Тьюринг опубликовал 28-страничную статью под названием «Вычислительные машины и интеллект».

В ней он с первых строк задает заветный вопрос: «Умеют ли машины мыслить?».

Однако тут же предупреждает, что ответ зависит от толкования понятий «машина» и «мыслить» и не может быть дан с помощью методов статистики. Поэтому автор предлагает описать вопрос в терминах игры в имитацию.

В игре участвуют три человека: мужчина-А, женщина-В и исследователь-С (он может быть любого пола). Исследователь не видит и не слышит двух других игроков, а вся коммуникация ведется посредствам печатных сообщений. Задача исследователя состоит в том, чтобы задавать А и В вопросы и, ориентируясь только на их ответы, определить, кто из них женщина. При этом цель каждого игрока — убедить исследователя, что именно он является женщиной. Например, говорить «Не верь другому игроку! Это я женщина!»

Затем Тьюринг предлагает заменить участника А на машину и задается вопросом, будет ли в этом случае исследователь ошибаться так же часто, как в изначальном варианте игры. По сути, он меняет вопрос с «могут ли машины думать?» на «могут ли машины делать то, что могут люди (как мыслящие существа)?»

Статья стала поворотной точкой в истории машинного интеллекта. Она написана достаточно простым языком, использует аналогии из жизни, ее основные тезисы близки массовому читателю. Однако простота изложения вовсе не сделала ее доступной. Некоторые утверждают, что статья была проблемной с самого начала, и существование как минимум трех ее интерпретаций служит тому подтверждением. Тьюринг не поясняет, знает ли исследователь-С о том, что один из игроков является компьютером. Другие полагают, что цель теста Тьюринга — проверка гипотезы, что машина способна имитировать человека, а не ответ на вопрос, может ли она одурачить его.

Из-за расхождений в понимании слов ученого можно по-разному толковать успехи ИИ. Так, о прохождении машиной теста Тьюринга было объявлено уже в 1966 году, когда Джозефом Вейценбаумом была создана программа Элиза, которая сумела обмануть исследователя, притворяясь психотерапевтом. Критике подвергся как раз тот факт, что судья-человек не подозревал о том, что ему придется иметь дело с роботом, поэтому и не заподозрил ничего необычного.

К сожалению, сам Тьюринг уже не мог прокомментировать эксперимент — ученый покончил с собой в 1954 году.

За 70 лет существования теста, предложенного Аланом Тьюрингом, ИИ не раз пробовал свои силы, пытаясь пройти его. Множество людей, исполняющих роль исследователя-С, были уверены, что разговаривают с человеком из плоти и крови. Однако мы до сих пор не можем с уверенностью сказать, что машины могут делать то, на что способны люди в качестве мыслящих существ. Один из главных критиков теста Тьюринга Джон Сёрл, предложивший мысленный эксперимент «Китайская комната», утверждал, что можно свободно оперировать информацией без малейшего понимания этой информации.

Рассматривая изображение папы римского, уверенно шагающего по улице в модном пуховике Balenciaga, мы можем заподозрить, что что-то здесь не так. Однако у машины не возникает этого чувства (по крайней мере, на данном этапе развития ИИ). Когда человек просит у нейросети изобразить ему, как «сидели мужики и ели», он представляет картинку, где за столом сидят мужчины и что-то едят, однако ИИ воспринимает все буквально*.

Возможно, нам следует отказаться от антропоцентризма в вопросах, касающихся ИИ. Как говорил Кэмпбелл, мы должны представлять существо, которое думает так же хорошо или даже лучше, чем человек, но не как человек. Но в массовом сознании слишком крепко укоренилась мысль, культивируемая в том числе фантастикой, что интеллект машины должен походить на человеческий. Героиня рассказа Лестера дель Рея — робот, влюбляющаяся в своего создателя. Адамом Линком тоже движет любовь и высокоморальные принципы. Из недавних популярных произведений можно выделить игру «Детройт: стать человеком» 2018 года, сюжет которой завязан на том, что андроиды однажды начнут испытывать эмоции и проявлять эмпатию.

Создается впечатление, что человечество запуталось, чего именно оно хочет от ИИ.

С одной стороны, нас пугают перспективы восстания машин, которые рисовали нам фантасты на протяжении многих лет. С другой, мы с удовольствием общаемся с умным голосовым помощником и испытываем разочарование, когда андроид отвечает невпопад. Но будет ли человечество готово принять факт существования искусственного разума? Когда и при каких условиях это может произойти? До какой степени нужно развить ИИ, чтобы мы признали, что мышление не является исключительно человеческой привилегией? Популяризатор науки Тоби Хенди обратила внимание на эту проблему в своем видео, посвященном статье Тьюринга:

«Нам уже посчастливилось стать свидетелями многого из того, что представлял себе Тьюринг. Несмотря на это, многие из нас ничуть не приблизились к тому, чтобы рассматривать машины как мыслящие сущности. Мне интересно, подвергнется ли когда-нибудь человеческий дух проверке и какое испытание убедит нас в том, что машина сделала свои первые шаги в континууме разума?»

Краткая история капчи

Пока искусственный разум и связанные с ним философские проблемы будоражат воображение многих, прогресс в сфере искусственного интеллекта ставит перед людьми куда более бытовые задачи, с которыми они никак не ожидали столкнуться. Как понять, что домашку ученик сделал сам, а не ChatGPT? Как узнать, что фото человека на сайте знакомств не сгенерировано искусственно?

ИИ становится талантливее с каждым днем, и результат его деятельности все сложнее отличить от людского. Осознав эту проблему, компании, занимающиеся разработкой ИИ, поспешили создать инструменты для проведения такого отличия. Сама идея существования таких инструментов противоречит идее ИИ — ведь смысл в том, чтобы текст или картинка, созданные нейросетью, не отличалась от того, что могут создать люди. Неудивительно, что эти программы продемонстрировали малую эффективность. OpenAI утверждает, что ее детектор правильно определяет только 26% текстов, написанных машиной, как «вероятно написанных ИИ». Летом 2023 года The New York Times сравнила, насколько хорошо программы различают реальные и ИИ-картинки. Некоторые справлялись лучше, чем другие, пока очередь не дошла до винтажной фотографии супружеской пары рядом с йети. Все пять приложений сказали, что это реальное фото.

Помимо низкой эффективности, такие инструменты обладают еще одной проблемой. Их принцип работы заключается в том, что они ищут необычные закономерности в расположении пикселей, в том числе в их резкости и контрастности. Такие сигналы обычно генерировались при создании изображений нейросетями. Однако эти данные могут быть использованы для машинного обучения — и в обновленной версии нейросеть будет знать, что ей необходимо исправить, чтобы ее работа была максимально реальной.

Подобная история произошла с тестом на человечность, который проходил каждый пользователь интернета.

Капча (CAPTCHA) — автоматизированный публичный тест Тьюринга, разработанный в 2000 году аспирантом университета Карнеги-Меллона Луисом фон Аном. Будучи студентом первого курса аспирантуры, Ан посетил лекцию ведущего научного сотрудника Yahoo! — самой преуспевающей технической компании в мире на тот момент. Лекция была посвящена десяти проблемам, которые не могли решить лучшие умы компании. Проблема, заинтересовавшая Луиса, заключалась в том, что хакеры пытались получить доступ к миллионам аккаунтов пользователей Yahoo! для рассылки рекламных или мошеннических сообщений, и никто в компании не знал, как этому помешать. Было очевидно, что нужен некий тест, который поможет отличить программируемых ботов от реальных пользователей. Задача усложнялась тем, что машина не должна была знать, как пройти этот тест, но могла оценить, прошел ли его человек или компьютер. Луис вспоминал в интервью, что это была парадоксальная задачка.

Решение появилось, когда исследователи задумались, что может без особых усилий сделать среднестатистический человек, а робот нет. Сперва на ум пришла идея показывать людям картинки и просить дать ответ, что на них изображено. Например, пользователь видел изображение цветов и должен был написать «цветы». Однако вставал вопрос языкового барьера. Кроме того, люди мыслят по-разному, кто-то наверняка ввел бы «растения» и долго ломал бы голову над тем, почему его ответ неверен. Наконец, «вы удивитесь, насколько плохи люди в орфографии» — объясняет Луис причину отказа от первоначальной задумки. Но ученые были на верном пути.

Оставалось лишь добавить на показываемую картинку сам символьный ответ, который и требовалось ввести.

Капча представляет собой обратный тест Тьюринга, то есть в роли судьи-С выступает машина, чья задача — отличить ответы человека от робота. Технология демонстрировала пользователям искаженные изображения символов, которые нужно было правильно перепечатать, чтобы получить доступ к сайту. Этот метод был эффективен для предотвращения большинства автоматических атак, поскольку компьютеры того времени с трудом обрабатывали искаженный текст, а большинство людей с детства обладают навыком распознавания текста с разной степенью искажения.

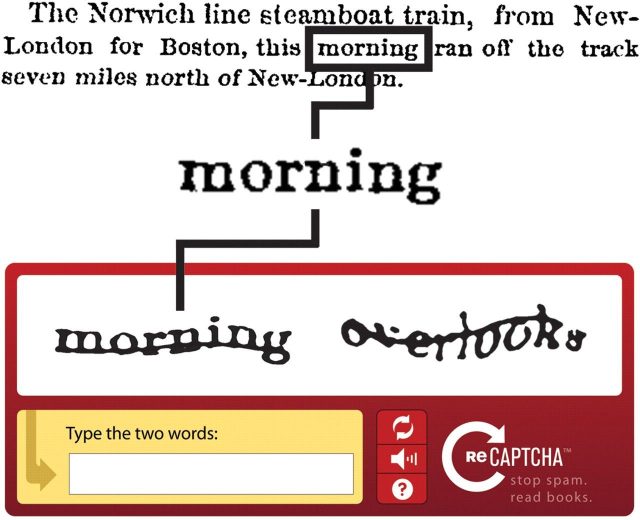

Создатель капчи также задумался над тем, что еще полезного можно сделать с ее помощью. В результате в 2007 году он представил рекапчу (reCAPTCHA). Она состояла из двух слов: символы одного компьютер знал и проверял, а другого ему были неизвестны. Второе слово было заимствовано из печатных архивов, оцифровкой которых тогда интенсивно занимались. Машина не могла распознать символы из-за плохой печати или других искажений. Тут-то на помощь и приходили люди, которые, впрочем, часто не подозревали, что помогают обучать машину распознаванию новых слов. Когда несколько пользователей одинаково вводили второе слово, компьютер добавлял его в базу данных, и отныне этот вариант искажения не был для него препятствием.

Задумка оказалась настолько удачной, что к 2014 году машины научились с легкостью расшифровывать даже самые искаженные тексты, с которыми у людей, наоборот, были большие проблемы. Google, выкупивший технологию в 2009 году, выяснил, что с самым сложным типом искажения справляется только 33% людей, в то время как машины правильно понимали символы в 99,8% случаев. Тем самым был нарушен сам смысл теста, согласно которому капча должна быть максимально простой для самого несмышленого человека, но максимально сложной для самого продвинутого робота.

В 2012 году рекапча начала использовать фотографии, взятые из проекта Google Street View. Чаще всего в таких тестах пользователей просили выбрать из множества фото изображения пожарных гидрантов, светофоров, пешеходных переходов — иначе говоря, объектов, связанных с дорожным движением. Возникло предположение, что гугл вновь использует пользователей интернета для своих целей. Дочерняя компания гугла Waymo, занимающаяся разработкой беспилотных автомобилей, как раз тогда была на слуху, и многие считали, что рекапча помогает обучать ее умные транспортные средства. Однако представитель компании опроверг это, заявив, что такие тесты лишь помогали улучшать гугл-карты.

В 2013 году принцип теста вновь изменился с выходом NoCAPTCHA reCAPTCHA. На сей раз пользователям не нужно было ломать голову, пытаясь расшифровать искаженные каракули или отличить дерево от кустарника. Требовалось лишь поставить галочку, кликнув мышкой в нужном месте. После всех предыдущих версий капчи это испытание казалось смешным, однако именно оно призвано было стать самым надежным.

Эта капча не ждет от пользователей правильного ответа — она следит за поведением.

Анализируется ваш образ действий на сайте, скорость реакции, даже траектория движения курсора. Если компьютер заподозрит, что вы поставили галочку слишком быстро, слишком прямо провели курсор или сделали что-то еще «неестественное», вас попросят пройти вторую часть теста все с теми же картинками. Гугл хранит в секрете принцип технологии, поэтому, возможно, вторая часть тоже основана на анализе поведения. Скорее всего, если вас просят указать все квадратики с изображением светофора, вы можете не отмечать 2 миллиметра, залезающие на соседний участок. Но и случайным образом кликать по траве не стоит.

Еще более современные капчи вообще не требуют от пользователя никаких действий, мы их даже не видим. Вся магия происходит за сценой — машина анализирует нашу историю взаимодействия с сайтом и делает вывод, человек ли перед ней или нет.

Однако в наши дни, когда ИИ развивается с пугающей скоростью, капча уже не является надежным методом борьбы с ботами. Очевидно, что необходимо пересмотреть критерии, отличающие людей от машин. Впрочем, некоторые ученые, среди которых и сам создатель капчи, уверены: в обозримом будущем компьютеры «выиграют» игру в имитацию — и их деятельность будет неотличима от человеческой.