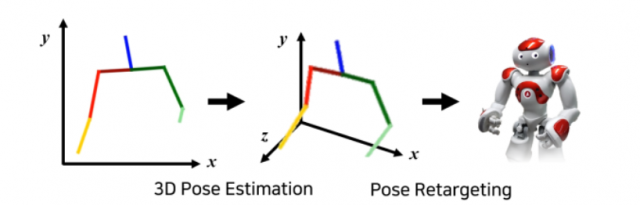

Корейские ученые научили робота жестикулировать по записям TED Talks. Трехмерной системе показали 52 часа выступлений спикеров, пишет N+1 со ссылкой на препринт научной статьи.

Жесты ораторов на видео были размечены с помощью открытого алгоритма OpenPose и соотнесены с акцентами в речи. В результате получилась трехмерная система, способная воспроизводить жесты.

Затем ученые попросили 46 добровольцев оценить по шкале от 1 до 5, насколько компьютерные жесты похожи на человеческие и соответствуют сказанному, чтобы отобрать самые точные движения.

По словам авторов исследования, гуманоидному роботу NAO, на котором испытали систему, удалось воспроизвести заданные комбинации жестов.