Опасности роботизации и техпрогресса: почему искусственный интеллект подобен армии обезьян

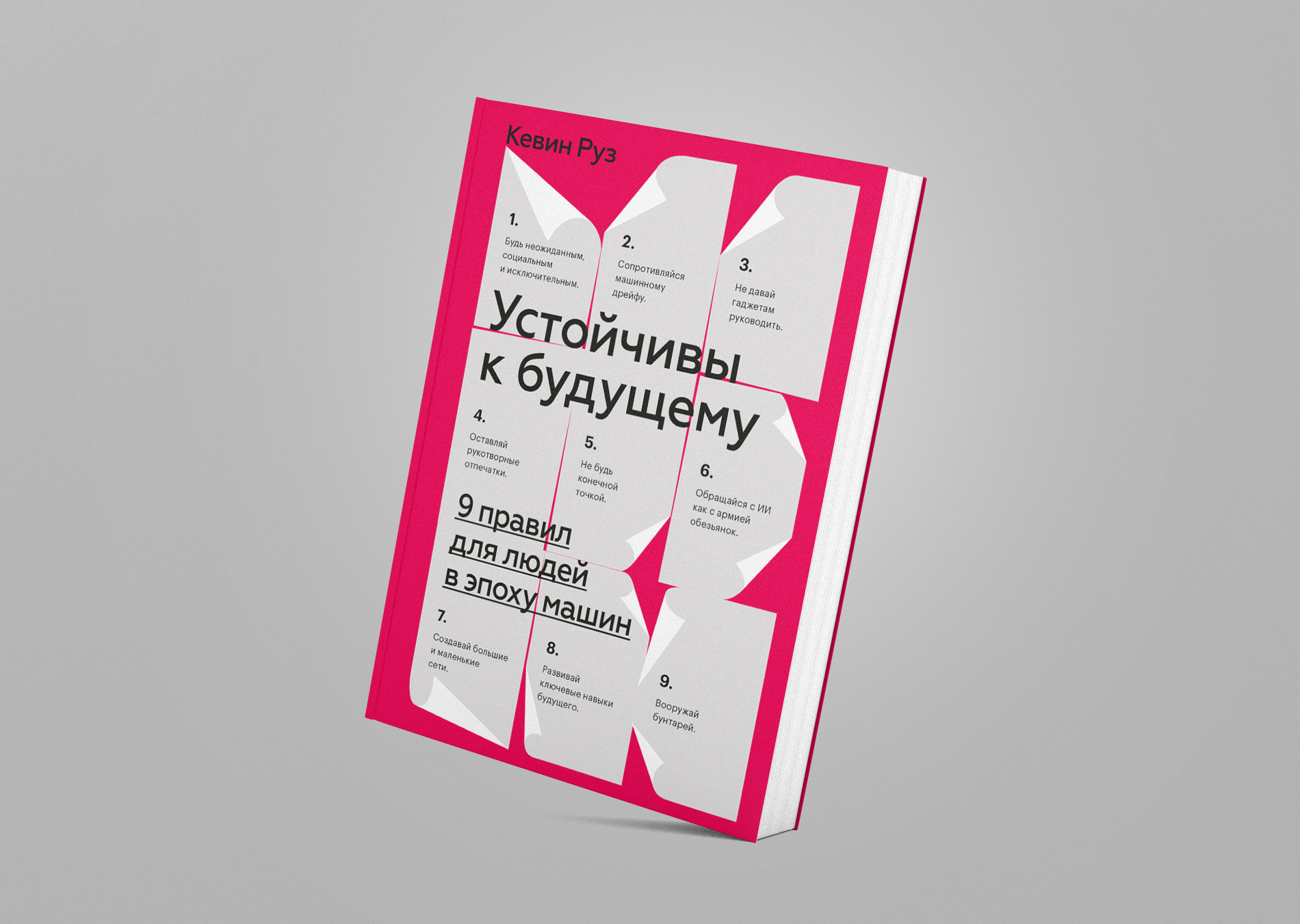

В издательстве «Манн, Иванов и Фербер» выходит книга журналиста и исследователя технологий Кевина Руза «Устойчивы к будущему. 9 правил для людей в эпоху машин». Руз исследует влияние технологического прогресса на общество и выводит правила, которых должны придерживаться люди, чтобы не лишиться работы из-за новой волны автоматизации. Публикуем фрагмент из главы, посвященной тому, почему к искусственному интеллекту следует относиться как к армии обезьянок.

«Мы решили техническую проблему, которая приводила на Facebook к ошибкам при переводе с бирманского на английский. Такого не должно было случиться, и мы принимаем меры для того, чтобы это не повторилось». Представитель Facebook приносит извинения за изъян в системе с технологией машинного обучения, которая перевела имя генерального секретаря ЦК компартии Китая Си Цзиньпина как «мистер Свинарник»

В тот день Майк Фаулер проснулся очень рано от жужжания телефона.

Шел 2013 год, было субботнее утро, но Фаулер, американский предприниматель, живущий в австралийском Мельбурне, привык разбираться с деловыми письмами в неурочные часы. Он был основателем компании Solid Gold Bomb, торговавшей в интернете оригинальными футболками и другими предметами одежды, и всегда где-нибудь находился клиент или сотрудник, которому от него что-то было нужно.

Но в этот раз Фаулер, взглянув на экран телефона, заподозрил неладное. Несколько сообщений в Facebook от незнакомых людей, ругающих его последними словами. Срочное письмо от высокопоставленного руководителя Amazon. Просьба об интервью от BBC.

«Я подумал: о боже, что-то случилось», — рассказывал он мне.

У него внутри всё перевернулось, когда он понял, что произошло: его подвел его собственный алгоритм.

Год с лишним назад Фаулеру пришла в голову идея, которая произвела переворот в его компании. Он видел, что другие производители с помощью таргетированной рекламы Facebook продают футболки с надписями, представляющими собой слегка видоизмененные ходовые фразы, которые нацелены на очень специфическую аудиторию. (Может, вам попадалась такая реклама в ленте Facebook в 2012–2013 годах; речь о футболках с такими надписями, как «Не стоит недооценивать ФАНАТА CUBS [Chicago Cubs — американский профессиональный бейсбольный клуб. — Прим. перев.], родившегося в АВГУСТЕ» или «Прости, но я уже очарован сексуальной ДАНТИСТКОЙ-ГИГИЕНИСТКОЙ по имени ТЭММИ».)

И Фаулер подумал: а что, если сделать алгоритм, генерирующий надписи на футболках не для сотен микрогрупп, а для миллионов? Он написал простой скрипт, который брал слова из словаря, вставлял их в популярные афоризмы, автоматически создавал модели футболок с такими надписями и размещал каждую из них на Amazon в десятках вариантов расцветки и размеров.

Фаулер запустил алгоритм в «черную пятницу» 2012 года и к следующему понедельнику успел продать 700 с лишним футболок — больше, чем обычно за месяц. С этого момента дела стремительно пошли в гору. Алгоритм сгенерировал в интернете 20 миллионов всевозможных футболок, составив надписи на основе 1100 с лишним шаблонов. Не все из алгоритмически порождаемых фраз получались осмысленными, но это не имело значения. Страницы для товаров на Amazon создавались бесплатно, а надписи на футболках печатались по запросу; следовательно, в реальном существовании конкретной надписи не было необходимости, пока не объявлялся, например, фанат Cubs или дантистка-гигиенистка.

План казался гениальным до 2 марта 2013 года, когда один покупатель, просматривая товары на Amazon, наткнулся на футболки с возмутительными надписями — вариациями популярного призыва «Сохраняй спокойствие и продолжай в том же духе»; алгоритм вставил в него слова, которые Фаулер позабыл исключить из словаря.

Надписи, были, например, такие:

СОХРАНЯЙ СПОКОЙСТВИЕ И УДАРЬ ЕЕ

СОХРАНЯЙ СПОКОЙСТВИЕ И ЗАРЕЖЬ ЕЕ

СОХРАНЯЙ СПОКОЙСТВИЕ И НАСИЛУЙ НАПРОПАЛУЮ

Уязвленный покупатель опубликовал фотографии футболок в Twitter. И разразился скандал.

Когда Фаулер понял, что происходит, он зашел на Facebook и попытался объяснить, что надписи были сгенерированы автоматически, никто не видел их в реальности и не утверждал и таких футболок на самом деле не существует. Но было уже поздно. За нарушение правил Amazon изгнал Solid Gold Bomb из своего магазина, и через несколько дней Фаулеру пришлось рассчитать всех своих сотрудников и закрыть компанию.

Одна-единственная ошибка — то, что Фаулер позабыл вычеркнуть из словаря распространенных глаголов потенциально оскорбительные, — изменила всю его жизнь. Я разговаривал с ним через шесть лет после того происшествия, и он сказал, что случившееся до сих пор не дает ему покоя.

«Это был тяжелый удар, — сказал он. — Я так от него и не оправился».

Что бы вы сделали, если бы в один прекрасный день в ваш офис заявилась тысяча шимпанзе и попросила работы?

Если рассуждать здраво, вы, наверное, заперли бы дверь и вызвали службу отлова животных. Но на секунду забудем о здравом смысле и представим, что вы решили не паниковать, а попробовать найти для шимпанзе какое-нибудь задание.

При определенных обстоятельствах из этих приматов могут выйти отличные работники. Они сильные, шустрые и довольно умные. Их можно научить распознавать лица, поднимать и переносить предметы и даже выполнять простые команды. Можно представить себе, как группа хорошо обученных офисных шимпанзе погружает и разгружает товары на складе или меняет картриджи в лазерных принтерах.

Но, прежде чем давать обещания, вы, конечно, захотели бы узнать о шимпанзе побольше. Насколько они послушны? Бывало ли, что они проявляли агрессию? Как долго их нужно будет обучать и надо ли за ними присматривать? И если вы всё-таки решите впустить армию шимпанзе в свой офис, вы не сделаете этого тотчас же. Сначала вы, возможно, проведете оценку безопасности работы с шимпанзе или организуете рабочую группу по надзору за шимпанзе. Может, вы решите сперва взять нескольких обезьян, поместить их в одну комнату под строгим контролем, научить их делать что-то простое и посмотреть, что выйдет, и только потом поручать ответственные задания.

Но независимо от того, насколько вы готовы рисковать, я уверен, вы не впустили бы шимпанзе тут же, не раздали бы им бейджи на шнурках и не сказали бы: «Ну, за работу!» И уж точно не поручили бы им руководство.

Возможно, вы уже поняли, к чему я клоню.

В предыдущей главе мы говорили о том, что происходит, когда людей превращают в конечные точки, если процесс пока невозможно полностью автоматизировать и люди нужны для заполнения врéменных пробелов. Но есть и обратная проблема. Руководители многих организаций совершают ошибку, сверхавтоматизируя процессы: поручая машинам задания и давая полномочия, которые им не по плечу, а потом удивляясь, что дела идут из рук вон плохо.

В последние несколько лет я общался со множеством директоров, которых убедили, что ИИ — потрясающая, трансформирующая технология и внедрять ее на рабочих местах нужно однозначно, тут и думать нечего; это решение не более ответственное или рискованное, чем поменять заправку для салата в столовой. Им не терпится задействовать как можно больше машин — не только скучных бэк-офисных ботов RPA, но и настоящий ИИ, способный принимать важные административные решения, касающиеся стратегии и операций. Некоторые директора даже мечтают передать ИИ значительную долю собственных обязанностей. В статье, вышедшей недавно в MIT Sloan Management Review, двое директоров предсказали стремительное распространение «самоуправляемых компаний» — таких, где живых руководителей совсем немного и большинство важных решений, в том числе о приеме на работу и увольнении, принимается алгоритмами.

Эти люди, мягко говоря, выжили из ума. Любой специалист по информационным технологиям, работающий на переднем крае сферы ИИ и машинного обучения, скажет вам, что и лучшая из существующих систем ИИ пока далеко не достойна такого беспечного доверия.

Большинство сегодняшних систем ИИ подобны армии обезьянок. Они умны, но не так, как люди. Они способны выполнять указания, если их хорошо обучили и за ними тщательно следят, иначе могут вести себя непредсказуемо и оказывать разрушительное воздействие. ИИ тренируется и развивается многие годы и научился делать то, что человеку не под силу, например отсеивать спам из миллиарда электронных ящиков или генерировать миллион персонализированных плейлистов, но он не особо хорошо проявляет себя в незнакомых и ответственных ситуациях.

Один из моих любимых сайтов — AI Weirdness; это блог, который ведет Жанель Шейн, и начала она это делать, когда в докторантуре Калифорнийского университета в Сан-Диего изучала нейросети — вид ИИ, имитирующий способы обработки информации человеческим мозгом. Шейн заметила, что, когда она обучала нейросеть выполнять очередную задачу, та порой терпела крах, причем странно. Однажды Шейн учила нейросеть порождать клички для кошек на основании набора из восьми тысяч с лишним имен, полученного от приюта для животных. Программа проглотила список реальных кошачьих кличек и начала генерировать новые. Среди них оказались такие:

— Джендрина;

— Сонни; — Мроу;

— Джексли;

— Пикл;

— Марпер;

— Фоппин;

— Тоби Буч Сноупай;

— Биг Уигги Бул [Клички из списка звучат странно, большинство из них не имеет смысла. Те, что соответствуют реальным словам английского языка, кажутся абсурдными: Пикл (Pickle) — в переводе «рассол», Сноупай (Snowpie) — снежный пирог, Биг Уигги Бул (Big Wiggy Bool) — большой эксцентричный бул (под последним словом машина, возможно, подразумевала мяч (ball) или быка (bull)). — Прим. перев.].

В другой раз Шейн обучала нейросеть генерировать рецепты коктейлей. Первым, что выдала машина, был рецепт напитка под названием «Мораль и фоп нгаба», и выглядел он так:

1,5 унции апанас

1 лнции сока крилпи

1 чайная ложка амельсиковых соков

Добавьте белкаплы

Лугрйте в бокал для кокпейля

Шейн, вероятно, поругала бы меня за то, что я оказываю ИИ слишком много чести, уподобляя его шимпанзе. (Онато употребляет другое зоологическое сравнение: по ее словам, «у ИИ мыслительные способности примерно на уровне червяка».) Без тщательного человеческого надзора, пишет она, ИИ может допускать не только забавные, безобидные ошибки, но и по-настоящему опасные.

«Поскольку системы ИИ склонны, сами того не понимая, решать задачи, отличающиеся от выданных, при этом всё руша и неудачно выбирая кратчайшие пути, — пишет Шейн, — людям нужно следить, чтобы от их „блестящих решений“ не пришлось потом схватиться за голову».

Но, очевидно, это предостережение не достигло ушей людей, принимающих решения в американских корпоративных кругах: кажется, они по-прежнему слишком полагаются на мудрость ИИ, и часто это приводит к последствиям куда более серьезным, чем непреднамеренная реклама футболок с оскорбительными надписями или публикация отталкивающего рецепта.

Так, 1 августа 2012 года брокерская компания Knight Capital потеряла 440 миллионов долларов всего за 45 минут из-за того, что неправильно установленная автоматизированная торговая система очень быстро скупила и продала миллионы акций; их стоимость подскочила, а когда их пришлось продавать, компания понесла огромные убытки. Knight Capital оказалась на грани разорения, и удержаться на плаву ей позволило только экстренное финансирование объемом в сотни миллионов долларов.

Или возьмем Watson, IBM-овскую систему ИИ, которая, как известно, в 2011 году выиграла у рекордсмена Jeopardy!. В 2013 году IBM в сотрудничестве с Онкологическим центром им. М. Д. Андерсона при Техасском университете начала разрабатывать программу на базе Watson, которая подбирала курс лечения для онкобольных. Но обнаружились изъяны. В 2018 году внутренняя проверка, результаты которой оказались в распоряжении новостного сайта о здоровье Stat, выявила, что Watson неправильно обучали: в основу была положена информация не о реальных, а о вымышленных, абстрактных пациентах, и в результате система иногда давала неверные рекомендации. Сообщалось, например, что однажды Watson порекомендовал врачам дать шестидесятидвухлетнему раковому больному с обильным кровотечением лекарство, которое могло усилить процесс. (IBM в заявлении для Stat утверждала, что «обучение и совершенствование Watson Health опиралось на непрерывную обратную связь с клиентами, новые научные данные и новые формы лечения рака».)

Читайте также

Изъяны в системах ИИ часто приводят к ущемлению уязвимых групп, поскольку данные для обучения алгоритмов нередко берутся из источников, отражающих предвзятое отношение к этим людям. Например, много данных по арестам, используемых при обучении программ «профилактической полицейской деятельности» для органов правопорядка, отражает повышенное внимание к населению черных и латиноамериканских кварталов на протяжении десятков лет, а также расоводискриминационный характер таких мер, как остановка на улице с последующим обыском. Рекомендациями одного печально известного правоохранительного алгоритма под названием «Оценка необходимости альтернативных исправительных мер по отношению к нарушителям» (Correctional Off ender Management Profi ling for Alternative Sanctions, COMPAS) суды пользуются при вынесении приговора обвиняемым: программа вычисляет, насколько велика в каждом случае вероятность повторного нарушения закона. Исследование, проведенное в 2016 году некоммерческой организацией ProPublica, показало, что темнокожих подсудимых COMPAS объявляет будущими рецидивистами почти вдвое чаще, чем белых.

По всему миру дефектным и неопробованным автоматизированным системам и ИИ доверяют невероятно важные решения. Да, некоторые правительства, компании и организации, внедряющие такие системы, может, и поступают правильно: внимательно и придирчиво оценивают новые алгоритмы; моделируют риски и планируют сценарии, разбираясь, что может пойти не так; обеспечивают полноценный человеческий контроль на рабочих местах. Но многие этого не делают. А просто распахивают двери, впуская к себе армию шимпанзе и надеясь на лучшее.

Йошуа Бенжио, первопроходец в сфере глубокого обучения, — один из тех, кто, казалось бы, будет выступать за вовлечение ИИ в любой процесс принятия серьезных решений. Но в интервью журналисту Мартину Форду в 2018 году он высказался категорически против использования ИИ, когда решаются жизненно важные вопросы: например, на сколько осужденный преступник сядет в тюрьму.

«Люди должны уяснить, что у нынешнего ИИ и того, чьего появления можно ожидать в обозримом будущем, нет и не будет нравственного чутья и понимания, что хорошо и что плохо, — сказал Бенжио. — Только безумец доверит такие решения машинам».

Даже те, кто свято верит в возможности ИИ, например CEO Tesla Илон Маск, убеждаются на собственном опыте, как опасно наделять автоматизированные системы чересчур большими полномочиями. В 2018 году Tesla не удавалось выполнить план по выпуску седана Model 3 отчасти из-за неисправной работы заводского машинного оборудования, зависевшего от системы автоматических конвейеров.

После того как произошло несколько неприятных заминок с производством, Маск остановил конвейеры и заменил машины людьми. Производство ускорилось и выправилось, и компания выполнила план. Маск, считающий (не будем это забывать), что сверхумный ИИ в конце концов превратится в угрозу для человеческой цивилизации, позже признал, что поступил неверно, наделив машины такими большими полномочиями.

«Избыточная автоматизация на Tesla была ошибкой, — написал он в твите. — Мы недооцениваем людей».